欢迎user

2023开年,人工智能赛道最火热的话题非“ChatGPT”莫属。ChatGPT是由人工智能实验室OpenAI研发的聊天机器人程序,在GPT-3大模型基础之上演化而来。作为一款AI驱动的自然语言处理工具,ChatGPT能够通过学习和理解人类的语言来进行对话,还能根据聊天的上下文进行互动,协助人类快速完成邮件撰写、诗歌创作、代码编程等一系列复杂任务。

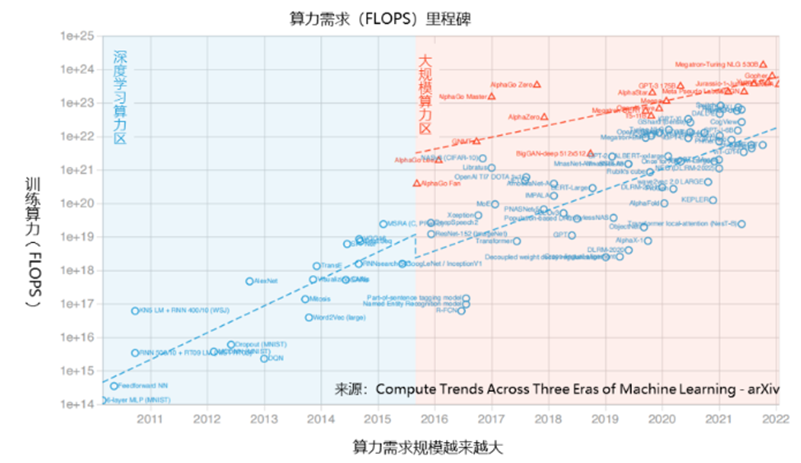

ChatGPT的火热,再度点燃了人工智能赛道,但作为典型的大模型训练场景,以ChatGPT为代表的AI应用的蓬勃发展,也催生出极高的算力需求。根据相关统计,训练GPT-3大模型的总算力消耗约为3640PF-days,这背后大约是285000个CPU、10000个GPU和每秒400G的网络所产生的强大算力。

ChatGPT如此大规模、长时间的大模型训练,对算力、网络底座的性能、成本等方面都提出了极致要求。作为数字化解决方案领导者,紫光股份旗下新华三集团持续深耕人工智能领域,在新华三看来,大模型训练需要跨越巨量AI算力、网络通信延迟以及高能耗三道门槛,新华三基于硬件使能、前瞻技术、绿色低碳等全方位能力,助力人工智能模型训练突破算力、网络等方面的瓶颈,加速推进人工智能产业的高质量发展。

软硬件全栈实力

助力算力基础设施提质升级

在底层硬件算力支撑上,新华三集团服务器产品可覆盖从AI训练到推理的全场景,以面向ChatGPT这类大规模AI训练场景的GPU服务器H3C UniServer R5350 G6为例,基于AMD Genoa平台实现了90%的CPU性能提升和50%的内核数量提升;支持GPU/NPU/xPU等多种人工智能加速卡,可应对人工智能不同场景下对异构算力的需求。此前,新华三GPU服务器在MLPerf™国际权威AI基准性能竞赛中,一举夺得BERT-large(自然语言处理)、DLRM(推荐)等模型测试86项世界第一,在单线程模式下,BERT推理时延仅为1.53毫秒,可大幅减少训练时间,实力诠释了其对于大规模、多元化、高复杂度AI场景的支撑能力。在2023年上半年,新华三还将发布基于Intel Eagle Stream平台的GPU服务器R5300 G6,敬请关注。

此外,面对AI作业调度、集群管理等难题,新华三集团推出智能算力中枢,为人工智能提供全场景的算力调度,实现了智能标注、智能匹配、智能训练、智能调优、智能推理五维智能的AI开发全流程支持,全面提升AI作业效率达32%,加速数据中心业务腾飞。

除了复杂的大模型训练场景,对于刚刚踏入AI领域的用户,新华三集团也面向广大AI开发者,免费开放H3C小智AI实验室,让用户体验真实的AI训练全流程。以小智AI实验室的问答机器人模型为例,问答机器人基于BERT模型,与ChatGPT同属于基于Transformer架构开发出来的NLP场景大模型,用户只需简单几步,即可在小智AI实验室训练和部署专属的问答机器人,了解问答机器人背后的技术原理。

让网络设备参与计算

提升分布式计算效率

与此同时,随着GPU算力的不断增长,网络通信能力日渐成为人工智能模型训练成熟发展的瓶颈,数据显示,过去5年GPU算力增长近90倍,而网络带宽仅增长10倍。受网络通信能力的限制,分布式集群的运算效率无法随其规模线性增长。

作为算网融合核心技术之一的“在网计算”技术,通过让网络设备参与计算,成为提升机器学习效率、突破集群计算效率瓶颈的有效解决方案。在网计算是通过在网络中部署对报文进行解析的算力,将部分计算任务从主机侧迁移至网络侧,由交换机、路由器、智能网卡、DPU等设备或部件完成计算加速的技术。在不改变业务原有运行模式的前提下,在网计算能够减少计算节点之间的消息交互,降低通信延迟,从而提高网络带宽利用效率,加速HPC和AI分布式计算效率。

基于在网络和计算领域深厚的技术积淀,新华三集团主动担起在网计算技术的产业化探索职责,快速在网络设备端完成研发落地,推出了全面支持在网计算的H3C P4可编程交换机,将有效解决HPC和AI分布式计算的集合通信问题,为提升数据中心的集群规模带来了新的方案和思路,同时也将进一步加速算网融合“网络计算化”演进,推动网络从连接算力到感知、承载、调配算力的角色升级,助力算网融合纵深发展。

平衡高速传输与低功耗

以CPO技术助力绿色数据中心建设

面对ChatGPT等高算力场景,网络作为关键基础设施支撑也正在向高带宽、低功耗、低时延方向优化演进。从底层技术来看,高速传输与低功耗之间的平衡是永恒的难题。基于能效和成本的考虑, CPO(Co-packaged optics,共封装光学)技术站上风口,成为炙手可热的高能效比解决方案之一。

CPO是指将光模块和交换芯片共同封装在同一个插槽上,形成芯片和模组的共封装,交换芯片和光模块间信号传输距离的缩短,显著提高了高速电信号的传输质量,能够解决信号高速传输和降低功耗的平衡难题,满足ChatGPT等高算力场景下网络高带宽、低功耗、低时延、小体积的需求。

作为网络进化和变革的引领者,新华三集团前瞻布局CPO技术,于2022年正式发布了400G硅光融合交换机,全面支持2.5D CPO技术(即NPO硅光技术)。相比传统的400G交换机,其交换容量可平滑升级到51.2T,单端口功耗可降低40+%,高性能网络支撑高算力需求,加速算力的释放,助力绿色数据中心建设。

从计算到网络,从硬件到软件,新华三集团以全栈技术实力赋能AI产业加速创新。面向AI新时代,新华三将继续秉持“内生智能”的技术理念,为人工智能的发展提供更强大的AI基础设施,打造更坚实的算力底座,以全面深化的智能驱动数字经济高质量发展。