-

-

< 返回

-

-

< 返回

-

-

< 返回

-

公司刊物

- 如何购买

- 案例中心New

- 数字化领航直播间

- 云上展厅

- 新华三商城

-

登录

退出

欢迎user

-

国家/地区

AI训练场景对网络提出的三大核心挑战

-

算力联接规模大

-

AI大模型训练规模已跃升至数十万卡,400G/ 800G高速组网成为核心支撑,单设备高速端口数值接决定超大规模集群的组网能力

-

算力联接效率低

-

硬件性能瓶颈、传统协议丢包率高及AI流量突发,持续制约高算力连接效率;MoE模型普及带来 All-to-All流量激增,进一步加剧网络压力

-

算力联接可用率低

-

复杂组网人工开局低效,AI训练流量突发监控缺失和跨域故障难回溯,导致智算场景算力联接可用率大幅降低

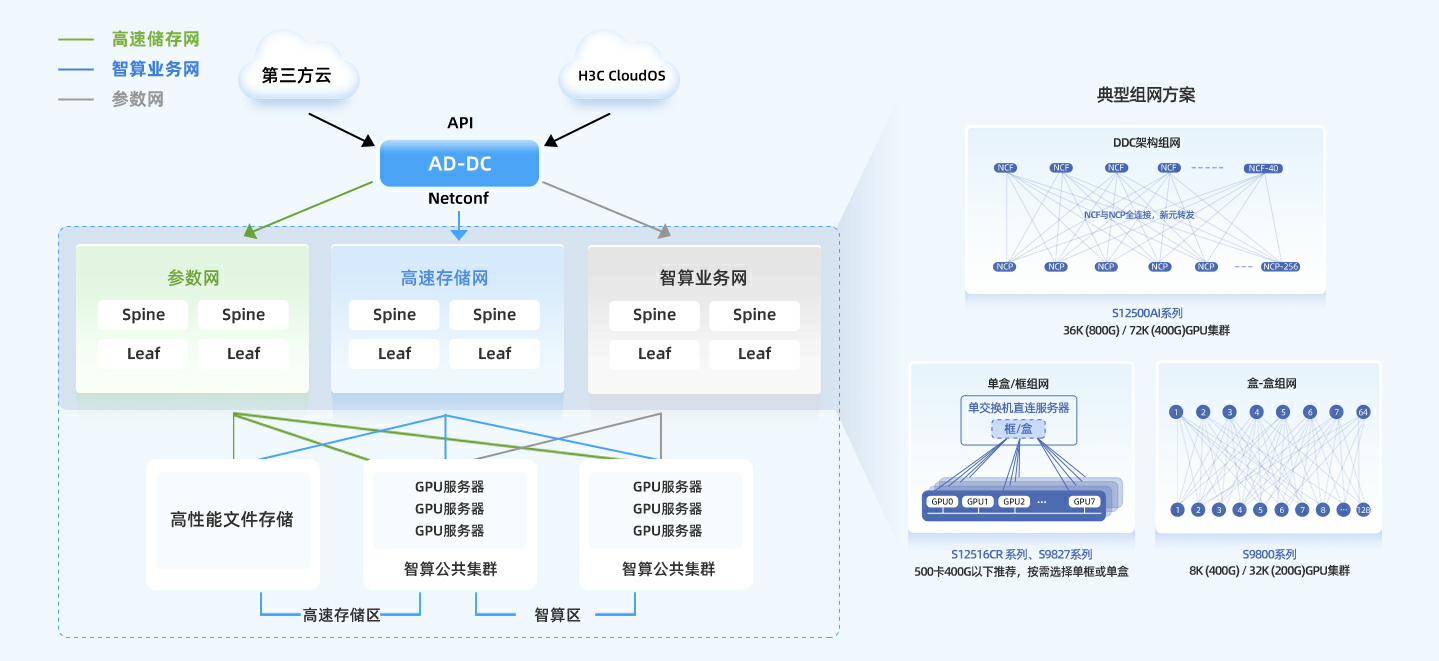

智算网络解决方案

组网架构

组网架构

方案核心优势

以超大规模组网能力、超高通信效率和超优运维保障,构建高效、稳定、可扩展的AI算力基础设施,支撑千卡到万卡级大模型训练平滑演进

-

超大规模

-

依托业内最完整的盒式/框式组网方案,实现单POD大规模组网能力达到行业主流水平的16倍

支撑万卡级集群建设,有效突破大模型训练中的联接规模瓶颈

-

超高效率

-

独创"多轨架构+路径导航"技术组合,训练效率提升20%

DDC架构实现100%负载均衡,All to All场景下性能表现媲美InfiniBand方案

-

超优运维

-

端网融合部署,开局效率提升10倍

端到端硬件健康状态全息感知,可靠性提升10倍

AI训练全程可跟踪、问题可追溯,提升排障效率

智算网络关键技术解析

基于DDC架构的新一代无损网络方案

Scale-out &Scale-up谁才是智算中心关键互联技术

智算中心“Pod 从“小房子”到“大house”加速AI训练与推理

探秘智算之SprayLink逐包喷洒技术

探秘智算之LBN端口对称HASH技术

VOQ+Credit 根治网络阻塞

为什么需要更加开放解耦的智算网络中心

探秘智算网络负载均衡技术(一):LBN

探秘智算网络负载均衡技术(二):DLB

如何打造算力持续增长的AI智算中心?(一)

如何打造算力持续增长的AI智算中心?(二)

最佳实践

- 互联网

- 科研机构

- 大型企业

互联网企业是指以计算机网络技术为基础, 利用网络平台提供服务并因此获得收入的企业。这些企业可以分为广义和狭义两种。

科研机构

互联网企业是指以计算机网络技术为基础, 利用网络平台提供服务并因此获得收入的企业。这些企业可以分为广义和狭义两种。

大型企业

互联网企业是指以计算机网络技术为基础, 利用网络平台提供服务并因此获得收入的企业。这些企业可以分为广义和狭义两种。

新闻资讯

2025-09-02

小红书携手新华三落地国内首个DDC架构智算网络集群

2025-08-21

新华三重磅亮相未来网络发展大会 以全栈创新引领智算变革

2025-09-15

新华三携手ICC讯石完成业界首次CPO直连800G光模块实时互联演示

2025-09-11

新华三出席2025开放数据中心大会 全景呈现AI智算网络创新技术

2025-08-22

单芯片102.4T | 新华三发布新一代800G AI智算交换机

2025-06-23

新华三发布800G国芯智算交换机,构建面向多元算力的网络新基座

2025-05-13

新华三张鸿凌:多维技术创新深化端网协同 构建开放多元智算生态

2025-04-23

新华三发布基于DDC架构的新一代无损网络解决方案

2025-04-24

深度解读:新华三基于DDC架构的新一代无损网络解决方案

2025-06-12

算网协同 创新升级:新华三出席中国智算中心全栈技术大会

2025-06-23

新华三出席CFCF2025,携手产业链推进智算场景高速光互连技术商用落地

2024-05-07

新华三李玉涛:摆脱AGI蛮力计算, 异构算力网络成为“必选项”

2024-09-05

新华三以开放、标准的联接技术,响应智算时代网络变革

2024-08-29

新华三:推动开放解耦,引领智算网络技术创新

2024-08-27

新华三算力集群交换机斩获未来网络创新科技

新华三算力集群交换机斩获未来网络创新科技

成果奖

2024-07-29

业界首家!新华三通过自智网络能力L4级标准认证

2024-07-15

新华三智算网络解决方案荣登2024信息通信业 “新质推荐”

2024-04-26