创建任务

用户可以创建自定义任务,步骤如下:

选择任务的类型,任务类型包括:SparkJar、Java、MR、Shell、PySpark,各类型任务需要配置的参数不同,详细说明请参见:

参数配置完成后,单击<保存>按钮,任务创建完成。

SparkJar任务

新建任务时,任务类型选择SparkJar,需配置的参数说明如下表所示。

表-1 SparkJar任务参数说明

|

参数名 |

描述 |

|

任务名称 |

配置SparkJar任务的名称 |

|

主类 |

配置SparkJar任务的驱动类类名,含包路径 |

|

主类Jar |

配置SparkJar任务主类所在Jar包名称 |

|

依赖文件 |

上传SparkJar任务的依赖文件,也即资源文件,需要为ZIP格式的压缩包,压缩包中需内部包括conf和lib两个目录,详细说明请参见依赖文件说明 |

|

描述 |

配置SparkJar任务的描述信息 |

|

模式 |

配置模式,模式是对主类入参的说明,例如对scala中main方法的入参进行说明 模式中可以配置多条说明,包括字段名、描述、key、类型和是否必填,点击后方的 可以配置三种模式,三种模式间是或关系,只能同时使用三种模式的一种 |

|

高级参数 |

单击<高级参数>按钮后,页面中出现配置项、Prepare和spark-opts参数:

|

Java任务

新建任务时,任务类型选择Java,需配置的参数说明如下表所示。

表-2 Java任务参数说明

|

参数名 |

描述 |

|

任务名称 |

配置Java任务的名称 |

|

主类 |

配置Java任务的驱动类类名,含包路径 |

|

依赖文件 |

上传Java任务的依赖文件,也即资源文件,需要为ZIP格式的压缩包,压缩包中需内部包括conf和lib两个目录,详细说明请参见依赖文件说明 |

|

描述 |

配置Java任务的描述信息 |

|

输出参数名称 |

配置任务的自定义输出参数名称和描述。可在业务流程中的下游节点中将自定义输出参数作为输入参数,实现作业间的参数传递 |

|

模式 |

配置模式,模式是对主类入参的说明,例如对Java中main方法的入参进行说明 模式中可以配置多条说明,包括字段名、描述、key、类型和是否必填,点击后方的 可以配置三种模式,三种模式间是或关系,只能同时使用三种模式的一种 |

|

高级参数 |

单击<高级参数>按钮后,页面中出现配置项、Prepare和java-opts参数:

|

MR任务

新建任务时,任务类型选择MR,需配置的参数说明如下表所示。

表-3 MR任务参数说明

|

参数名 |

描述 |

|

任务名称 |

配置MR任务的名称 |

|

configClass |

通过Java配置MapReduce任务时,需要实现OozieActionConfigurator接口,在工作流的config-class元素下,配置该实现类。此处参数配置即填写实现了OozieActionConfigurator接口的类全名 |

|

依赖文件 |

上传MapReduce任务的依赖文件,也即资源文件,需要为ZIP格式的压缩包,压缩包中需内部包括conf和lib两个目录,详细说明请参见依赖文件说明 |

|

描述 |

配置MR任务的描述信息 |

|

配置项 |

指定Mapper类和Reducer类等MapReduce客户端配置参数。支持配置多项,点击后方的 |

|

Prepare |

对应Oozie中的prepare标签元素,用于创建或者删除指定的HDFS目录 |

Shell任务

新建任务时,任务类型选择Shell,需配置的参数说明如下表所示。

表-4 Shell任务参数说明

|

参数名 |

描述 |

|

任务名称 |

配置Shell任务的名称 |

|

主文件名称 |

配置Shell脚本执行的入口文件名称,包含后缀 |

|

依赖文件 |

上传Shell任务的依赖文件,也即资源文件,需要为ZIP格式的压缩包,压缩包中需内部包括conf和lib两个目录,详细说明请参见依赖文件说明 |

|

描述 |

配置Shell任务的描述信息 |

|

输出参数名称 |

配置任务的自定义输出参数名称和描述。可在业务流程中的下游节点中将自定义输出参数作为输入参数,实现作业间的参数传递 |

|

模式 |

配置模式,模式是对主执行文件入参的说明 模式中可以配置多条说明,包括字段名、描述、key、类型和是否必填,点击后方的 可以配置三种模式,三种模式间是或关系,只能同时使用三种模式的一种 |

|

高级参数 |

单击<高级参数>按钮后,页面中出现配置项和Prepare参数:

|

PySpark任务

新建任务时,任务类型选择PySpark,需配置的参数说明如下表所示。

表-5 PySpark任务参数说明

|

参数名 |

描述 |

|

任务名称 |

配置PySpark任务的名称 |

|

主文件名称 |

配置待执行的Python脚本文件名称,包含后缀 |

|

依赖文件 |

上传PySpark任务的依赖文件,也即资源文件,需要为ZIP格式的压缩包,压缩包中需内部包括conf和lib两个目录,详细说明请参见依赖文件说明 |

|

描述 |

配置PySpark任务的描述信息 |

|

模式 |

配置模式,模式是对主执行文件入参的说明 模式中可以配置多条说明,包括字段名、描述、key、类型和是否必填,点击后方的 可以配置三种模式,三种模式间是或关系,只能同时使用三种模式的一种 |

|

高级参数 |

单击<高级参数>按钮后,页面中出现配置项和Prepare参数:

|

依赖文件说明

对于各类型的任务,选择依赖文件时,对依赖文件ZIP压缩包的目录层级和名称要求相同,即中需内部包括conf和lib两个目录。以PySpark任务为例:

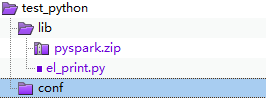

依赖文件ZIP格式压缩包中的文件目录结构如下图所示。

图-1 依赖文件压缩包内文件目录结构

其中test_python为最外层目录,其中包含lib和conf两个子目录。

如果应用程序有依赖的配置文件,则需要放到conf文件夹中;而任务执行程序以及依赖库文件,则需要放到lib文件夹中。如上图中所示,el_print.py为python程序主文件,pyspark.zip为主程序执行需要依赖的其他库文件压缩包(对python程序而言,依赖库文件需要打包为ZIP压缩包,并与主文件放在同级目录中),两个文件放到需要放在lib文件夹中。